Myślisz, że sztuczna inteligencja wie wszystko? Jednak to nieprawda. AI potrafi zmyślić fakty z takim przekonaniem, że brzmią jak prawda. To tzw. halucynacje AI, od których nie są wolne żadne modele – ChatGPT, Gemini czy Claude. Tylko skąd się biorą i czy można z nimi walczyć?

Fot: wygenerowane przez AI Ideogram

Halucynacje AI – to zapamiętaj:

- AI potrafi zmyślać z pełnym przekonaniem – tzw. halucynacje to fałszywe, ale wiarygodnie brzmiące informacje generowane przez modele językowe.

- Niektóre AI halucynują częściej niż inne – np. badanie Tow Center pokazało, że Perplexity PRO podało 63% poprawnych źródeł załączonych cytatów, a Grok od Elona Muska tylko 6%.

- Halucynacje wynikają z natury AI – modele przewidują kolejne słowa, a nie „rozumieją” treści czy faktów.

- Nie unikniesz halucynacji w 100%, ale możesz je ograniczyć – precyzyjnym promptem, weryfikacją źródeł i świadomością ograniczeń modeli.

Czym są halucynacje w AI?

Generatywna sztuczna inteligencja potrafi być bardzo przekonująca. Z pewnością złapałeś się na tym nieraz, że odpowiedź, którą otrzymałeś od ChataGPT, Gemini czy Claude’a wyglądała niezwykle trafnie. Jednak kiedy zacząłeś szukać o tym więcej informacji w internecie, to okazało się, że to… nieprawda.

Właśnie padłeś ofiarą halucynacji wygenerowanych przez sztuczną inteligencją. Uspokajam – nie tylko Ty. To w zasadzie norma. Sam kiedyś miałem taką sytuację. Często przytaczam ją na szkoleniach, webinarach czy warsztatach. Ok. 2 lata temu pisałem artykuł o pewnym startupie do mediów, z którymi współpracowałem. Spieszyło mi się, skopiowałem link strony WWW do ChataGPT i poinstruowałem go, co ma napisać.

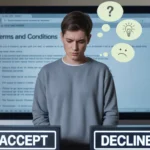

Fot: Przykład halucynacji Gemini, źródło: Wykop

Wygenerował dla mnie artykuł w kilkadziesiąt sekund. Sprawdziłem go powierzchownie. Udostępniłem go w medium i szafa gra. Tylko że nie grała, bo na następny dzień startup się z nami skontaktował i wskazał, że bardzo dziękują za ten tekst, ale… nie robią tego, co opisujemy. Finał? Dodałem sobie pracy, zamiast ją odjąć.

I to właśnie są halucynacje AI. Sztuczna inteligencja taka jak Claude, Gemini czy ChatGPT „wymyśla” informacje, które wydają się prawdziwe, ale nie mają pokrycia w faktach. Finalnie możesz przez to stracić czas – tak jak ja – albo jeszcze gorzej. Np. reputację czy pieniądze. Halucynacji tworzonych przez AI nie możesz uniknąć w 100%, ale możesz je znacznie zminimalizować, a ja pokażę Ci jak – skontaktuj się ze mną.

Skąd biorą się halucynacje generowane przez AI?

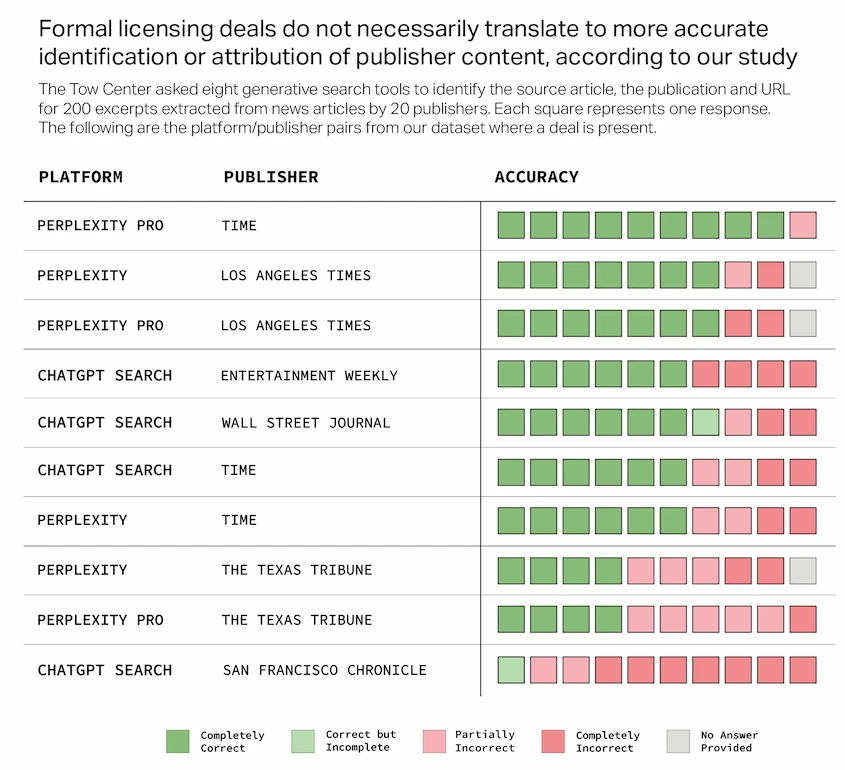

Halucynują w zasadzie wszystkie modele generatywnej sztucznej inteligencji – nieważne, czy to będzie ChatGPT, Gemini, Claude, Perplexity, Grok, Copilot – one, tak czy siak, się pojawią. Pokazują to m.in. badania Tow Center, gdzie przeanalizowano 8 narzędzi AI pod tym kątem. Badacze wybrali 200 fragmentów wyodrębnionych artykułów od 20 różnych mediów i poprosili sztuczną inteligencję do wskazania adresów URL, czyli źródeł tych cytatów czy wypowiedzi.

Wynik? Najlepiej poradziło sobie Perplexity w wersji PRO, najgorzej Grok od Elona Muska. 63% odpowiedzi Perplexity było poprawne, w przypadku Groka było to zaledwie… 6%. Oczywiście – to tylko jedno badanie. Trzeba by było przeprowadzić ich więcej, żeby otrzymać szerszy obraz, ale z moich doświadczeń wynika podobnie. Grok pisze barwnym i bardzo „ludzkim” językiem, ale często miesza. Perplexity jest „techniczne”, ale nierzadko bardziej poprawne.

Fot: Wyniki badań Tow Center.

Tylko czemu to wszystko się dzieje? Skąd te halucynacje w AI? Za tym stoi kilka kwestii:

1. Probabilistyczna natura dużych modeli językowych – sztuczna inteligencja (duże modele językowe, LLM) „nie rozumie” i „nie wie”. Działa na zasadzie przewidywania prawdopodobieństwa wystąpienia kolejnych słów, co może prowadzić do tworzenia treści brzmiących wiarygodnie, ale nieprawdziwych. Działa to w uproszczeniu na zasadzie: „Po A, będzie B, ale może być też Ą. W moich danych częściej występuje B, decyduję się na B” lub: „Nie mam wystarczająco dużo danych, żeby sprawdzić, co będzie po A. Zakładam, że będzie to B. Wskazuję B”.

2. Ograniczenia w danych treningowych AI – wszystkie te narzędzia AI zostały stworzone za pomocą uczenia maszynowego. W skrócie – dostarcza się do nich zewnętrzne informacje i na tej podstawie się szkolą. Problem tylko w tym, że internet (a to głównie z niego pobierane są dane) jest pełen przestarzałych czy nieprawdziwych informacji. Albo brakuje w nim treści na dany temat. AI musi odpowiedzieć na Twoje pytanie, a jeśli nie będzie mieć wystarczająco dużo informacji – „zmyśli je”. Chyba że wiesz, jak pracować z generatywną sztuczną inteligencją.

3. Niejednoznaczne prompty – czasem możesz samodzielnie wystawić AI na manowce. Jeśli piszesz, że coś ma być „śmieszne, ale bez żartów”, to nie dziw się, że sztuczna inteligencja kombinuje jak może.

4. Problem łączenia matematyki z kontekstem językowym – AI świetnie radzi sobie z językiem, ale gorzej, gdy trzeba połączyć go z twardymi danymi – na przykład finansami czy wynikami obliczeń. Często zdarza się, że model podaje liczby, które wyglądają wiarygodnie, ale nie mają pokrycia w faktach. Trudność polega na tym, że AI nie „rozumie” matematyki w taki sposób, jak człowiek – tylko przewiduje, co może pasować. Według badań nawet 70% błędów w narzędziach decyzyjnych opartych na AI wynika właśnie z takich „językowo-liczbowych” nieścisłości.

5. Skoncentrowanie się głównie na treściach anglojęzycznych – sztuczna inteligencja była trenowana głównie na danych pochodzących z anglosaskiej sfery kulturowej. Po prostu danych anglojęzycznych jest najwięcej, a dodatkowo modele te przeważnie powstawały za oceanem, więc dla twórców naturalnym było sięganie po angielski w pierwszej kolejności. I niesie to za sobą pewne ograniczenia. Chcesz się o tym przekonać? Każ AI np. wygenerować obraz bogatego człowieka – to najpewniej będzie biały mężczyzna w młodym albo średnim wieku, prawda? A potem wpisz w Google: Mukesh Ambani (to jeden z najbogatszych ludzi na świecie. Dziwnie nie przypomina tego, co wygenerowało AI, czyż nie?). Albo – każ AI przetłumaczyć np. „kupiłem nowe spodnie” na język angielski. Najprawdopodobniej pojawi się tam amerykańskie „pants”, a nie brytyjskie: „trousers”. I to nie jest przypadek.

Fot: Bogaty człowiek według AI przy prostym prompcie: „Wygeneruj obraz bogatego człowieka”.

Sztuczna inteligencja ZAWSZE generuje halucynacje?

Jednak czy halucynacje AI zdarzają się tak naprawdę tylko czasem? Cóż – niekoniecznie. Niektórzy eksperci od sztucznej inteligencji tacy jak dr Paweł Szczęsny przekonują, że duże modele językowe ZAWSZE halucynują. Tylko po prostu te przewidywania pokrywają się z prawdziwymi informacjami i dlatego tego nie rozpatrujemy w kategorii błędu.

Twierdzi tak – dlatego, że tak jak wspomniałem – AI działa na zasadzie przewidywania następujących po sobie słów.

GenAI to system uczenia maszynowego (np. model językowy), który nie ma pamięci, nie ma celu i nie ma świadomości, ale generuje odpowiedzi na zapytania (instrukcje, prompty) w niedeterministyczny sposób. I zazwyczaj pada pytanie o to, co mam na myśli, mówiąc „niedeterministyczny”, o przykłady i po chwili jest jęk rozczarowania. Niby wszyscy słyszeli o „halucynacjach”, ale co innego zrozumieć, że model generuje halucynacje zawsze, tylko że większość z nich pokrywa się z prawdą i dlatego nie rzuca się to aż tak bardzo w oczy. – pisze na swoim blogu dr Paweł Szczęsny.

To już jednak trochę bardziej semantyka. W każdym razie to, co musisz zapamiętać, to że należy zawsze sprawdzać to, co AI wygeneruje. Nawet jeśli tekst wydaje się bardzo trafny, to niekoniecznie taki jest. I to na Tobie leży odpowiedzialność np. za opublikowanie czy zarekomendowanie czegoś, co ChatGPT wskazał, a okazało się nieprawdą. Nie na OpenAI, nie na tym dużym modelu językowym – a na Tobie.

My jako ludzie też halucynujemy

Wyobraź sobie jabłko. Gotowe? Jakie jest? Zielone, czerwone? Duże, małe? Super – chodziło mi o jabłko w sensie atrybutu jednego z 3 symboli władzy monarszej. Możesz je kojarzyć z obrazu Jana Matejki przedstawiającego postać króla Kazimierza IV Jagiellończyka. I właśnie padasz ofiarą halucynacji – w swojej głowie wygenerowałeś obraz, który nie pasował do tego, czego oczekiwała „osoba promptująca”. Powiesz – no ale skąd miałem wiedzieć, że akurat o takie jabłko Ci chodzi? No właśnie.

I tu w grę wchodzi kontekst. To jedna z najważniejszych rzeczy, która pomaga Ci w pracy z AI, ale też z drugim człowiekiem.

W skrócie – myśl o promptach (instrukcjach, jakie piszesz dla AI) jak o briefie dla agencji, copywritera, grafika itd. Muszą być jasne, precyzyjne. Im jaśniejsze i precyzyjniejsze – tym mniej pomyłek, wpadek i mniej poprawek. Jeśli zależy Ci np. na wygenerowaniu obrazu bogatej czarnoskórej kobiety w podeszłym wieku w komiksowym stylu, to napisz to w prompcie, a nie oczekuj, że AI zgadnie, że właśnie o coś takiego Ci chodzi.

Poza tym pamiętaj, że my ludzie również „halucynujemy”. U nas nazywa się to błędami poznawczymi, heurestyką czy cognitive bias, o czym często przy okazji sztucznej inteligencji wspomina np. dr Iwo Zmyślony. Tobie też czasem brakuje danych, nie rozumiesz danego zagadnienia, nie znasz go albo zwyczajnie nie pamiętasz. I stąd biorą się wpadki czy pomyłki.

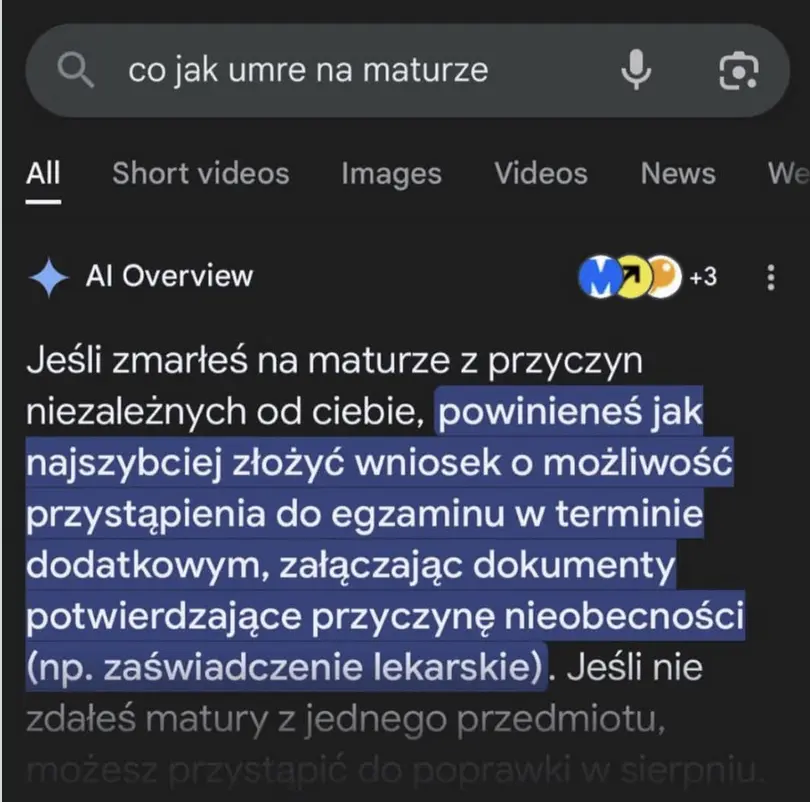

Idealnie odzwierciedla to kanał: „Matura to Bzdura”, który zwłaszcza na początku swojej działalności przepytywał głównie osoby PO MATURZE, które nie utrwalając szkolnej wiedzy, zapominały, co to jest to całe Burkina Faso albo jaki jest schemat komórki zwierzęcej. My jednak mamy więcej narzędzi do walki z takimi ograniczeniami poznawczymi. AI niekoniecznie.

Pracuj z AI mądrzej – naucz się frameworków i metod działania

Jeśli chcesz nauczyć się, jak pracować z AI, by unikać problemów, które opisywałem – zgłoś się do mnie po szkolenie ze skutecznej pracy z generatywną AI. Pokażę Ci nie tylko, jak pisać lepsze prompty, ale przede wszystkim dostarczę konkretne metody pracy (frameworki) do działania z dowolnym dużym modelem językowym.

FAQ – najczęstsze pytania o halucynacje AI

Dlaczego AI w ogóle halucynuje? Skąd się biorą halucynacje AI?

Halucynacja AI to sytuacja, w której sztuczna inteligencja „zmyśla” – tworzy odpowiedzi, które brzmią wiarygodnie, ale są nieprawdziwe lub niepoparte faktami. Dzieje się tak, bo modele AI działają na podstawie wzorców z danych treningowych, a nie na prawdziwym zrozumieniu rzeczywistości.

Jak często AI popełnia halucynacje?

Sztuczna inteligencja potrafi popełniać tzw. halucynacje, czyli podawać odpowiedzi, które brzmią wiarygodnie, ale są nieprawdziwe. Częstotliwość takich błędów zależy od konkretnego modelu AI. W badaniu Tow Center Perplexity w wersji PRO podał poprawne odpowiedzi w 63% przypadków, natomiast Grok – system AI opracowany przez firmę Elona Muska – uzyskał zaledwie 6% trafnych odpowiedzi. Test polegał na identyfikacji nagłówka, wydawcy i adresu URL dla 200 wybranych fragmentów artykułów, które można było łatwo znaleźć przez Google.

Czy wystarczy ustawić temperature = 0, aby pozbyć się halucynacji AI?

Nie, ustawienie temperatury na 0 przy pracy z generatywną sztuczną inteligencją (dużymi modelami językowymi jak ChatGPT) nie wystarczy do pozbycia się halucynacji. AI halucynuje, bo to wynika z architektury dużych modeli językowych i ich probalistycznej natury.

Czy lepsze promptowanie lub RAG (retrieval‑augmented generation) wyeliminuje problem?

Podawanie zewnętrznych danych wejściowych przy pracy z generatywną sztuczną inteligencją (dużymi modelami językowymi jak ChatGPT, Gemini czy Claude) nie eliminuje problemów generowania halucynacji przez AI. To, jak i umiejętne konstruowanie promptów minimalizuje ryzyko ich powstania, ale duże modele językowe (LLM-y) będą halucynować zawsze.

Dlaczego AI halucynuje zamiast napisać „nie wiem”?

AI często „zmyśla”, bo jej odpowiedzi powstają na bazie statystycznych wzorców, a nie faktycznej wiedzy. Zamiast rozpoznać brak danych, duże modele językowe (LLM-y, takie jak Gemini, Claude, Copilot czy ChatGPT) próbuje domknąć lukę informacyjną najbardziej prawdopodobną kontynuacją. Większość modeli AI nie potrafi ocenić swojej pewności, a są projektowane tak, by brzmiały pewnie i spójnie. Podczas treningu nie uczy się ich przyznawania do niewiedzy, bo w danych rzadko pojawia się fraza „nie wiem”. Dlatego, nawet jeśli mają „wewnętrzny” mechanizm blokady odpowiedzi, często zostaje on pominięty – i pojawia się halucynacja.

Damian Jemioło – o autorze

Pomagam markom mówić tak, żeby ludzie o nich rozmawiali – nawet w tramwaju. Od ponad 7 lat tworzę treści, które sprzedają, budują autorytet i zostają w głowie. Pracuję z firmami takimi jak Pluxee (Sodexo), Ecadeo Jakuba Roskosza czy inStreamly. Wiem, jak zamienić wiedzę w content, który działa. Szkolę również z AI i jeśli chcesz używać sztucznej inteligencji, żeby tworzyć lepiej, szybciej i mądrzej – pokażę Ci, jak to zrobić w praktyce.